Recentemente mi hanno chiesto di analizzare l’impatto dell’AI in termini di sostenibilità (in particolare energetica) sui datacenter e le loro architetture. Preparare il mio intervento mi ha dato l’opportunità di fare il punto su quello che sappiamo sull’impatto che il rapido progredire dell’AI può avere sulle risorse globali, sia in termini energetici che, forse ancora di più, in termini idrici.

Si leggono molti commenti sulla sostenibilità dell’AI, sia di natura positiva da parte di entusiasti sia ben più catastrofisti da parte di chi è più o meno giustamente preoccupato dall’avanzare di questa tecnologia.

Cerchiamo di fare il punto utilizzando i fatti e le informazioni note su AI e le risorse necessarie al suo funzionamento.

Indice degli argomenti

Software, consumo energetico, e parametri di un modello AI

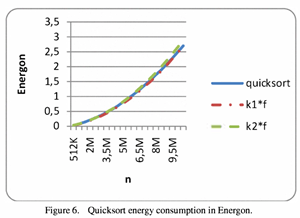

Per capire l’impatto in termini di risorse di un modello AI è necessario innanzitutto aver chiaro che esiste una correlazione scientificamente provata tra la complessità algoritmica di un software e il relativo consumo energetico (in figura si vede come la complessità algoritmica di un algoritmo di ordinamento si sovrapponga al consumo energetico necessario alla sua elaborazione).

In altre parole più un software calcola più energia sarà necessaria, non solo in termini di tempo di esecuzione, ma anche in termini di sottosistemi elettronici attivati all’interno dei chip per svolgere le operazioni necessarie. Si tratta di un fatto centrale poiché ormai tutti sappiamo che i modelli di AI sono definiti in termini di miliardi di parametri, richiedono ovverosia l’abilità di effettuare miliardi di operazioni per poter calcolare le attivazioni dei neuroni della rete neurale che è stata addestrata con enormi quantità di dati.

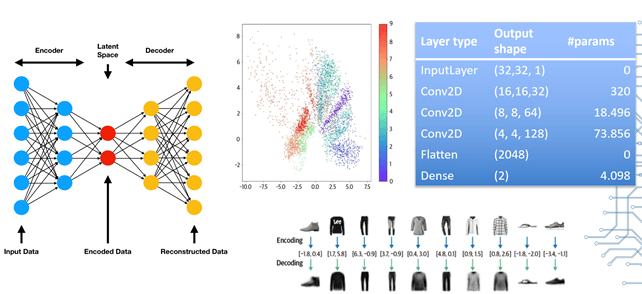

Ma perché sono necessari tutti questi parametri? Avendo meno problemi sarebbero necessarie meno risorse. Una rete neurale memorizza le proprie informazioni variando i pesi che rappresentano le connessioni tra neuroni digitali, il numero di parametri è quindi correlato alle informazioni che la rete sarà capace d memorizzare. Una semplice rete capace di generare immagini molto piccole (32 pixel per 32 pixel) richiede quasi centomila parametri.

Semplificando molto, l’addestramento di una rete è un processo iterativo che cerca di aggiustare i parametri per minimizzare l’errore tra coppie (input, output) elaborando numerose volte i parametri che, nel caso di LLM, possono essere decine di miliardi o addirittura un triliardo di parametri.

Non solo energia: quanta acqua consuma davvero l’IA?

Siamo tutti ormai abituati a qualche aggiornamento annuale dei grandi modelli, e nonostante non vi siano dati certi relativi ai megamodelli di OpenAI, Google o Anthropic, sono disponibili delle stime che sono comunque significative. L’aggiornamento non è più frequente a causa dei costi computazionali dell’operazione che per i grandi modelli può essere quantificata in milioni di dollari ad addestramento. Ad esempio, l’addestramento di un modello come Llama 2 70B (settanta miliardi di parametri) si stima sia costato 1,2MWh (per metterlo in prospettiva è il consumo annuale di circa 110 abitazioni europee) equivalenti a un’impronta circa 540 tonnellate di CO2.

L’energia non è però l’unica risorsa necessaria: per raffreddare i sistemi di calcolo utilizzati si usa l’acqua (addirittura portando il liquido a contatto con i processori e le altre componenti in un server per ulteriore efficienza) e per evitare la necessità di enormi compressori per raffreddarla i grandi datacenter fanno uso di una tecnica di raffreddamento chiamata evaporativa (l’evaporazione dell’acqua è il metodo più efficiente che comporta però la disponibilità di grandi quantità di acqua dolce poiché l’80% circa sarà dispersa nell’ambiente). L’acqua impiegata per l’addestramento di Llama 2 70B si stima essere 2,8 milioni di litri, poco più dell’acqua impiegata in una piscina olimpionica.

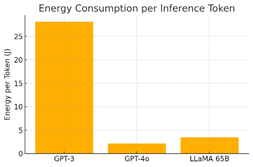

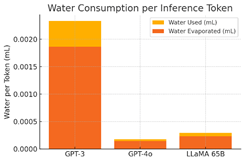

Da un punto di vista energetico si parla spesso dell’addestramento come costo significativo, ma sono disponibili anche stime dei costi energetici e idrici per token di un Large Language Model o LLM durante l’inferenza (pochi joule e milionesimi di litro per token anche per grandi modelli), si tratta di costi inferiori per singolo utilizzo del modello che però se moltiplicati per centinaia di milioni di utenti divengono più rilevanti dei costi di addestramento.

Ottimizzazione delle risorse: approcci hardware e software

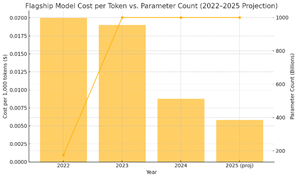

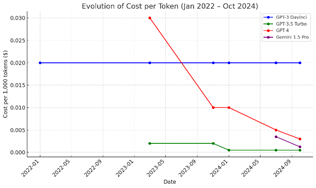

I costi energetici e idrici dell’AI sono sicuramente rilevanti, soprattutto con una grande porzione della popolazione mondiale che ne fa un uso sempre più intensivo, ma se consideriamo l’evoluzione del costo per token nel corso del tempo possiamo notare un calo significativo dei costi (che sono inevitabilmente legati ai costi di esercizio e quindi indirettamente agli assorbimenti energetici).

L’ottimizzazione di un modello, e di conseguenza il costo energetico, può essere ottenuta sia ottimizzando l’architettura hardware che lo esegue (e infatti oggi si parla di AI factories per i datacenter specializzati per l’esecuzione dei modelli AI) che ottimizzando il software e l’architettura della rete neurale. Ne è un esempio l’approccio MoE (Mixture of Experts) in cui una rete viene addestrata in modo da essere attivata solo in parte come se rappresentasse più esperti e all’inizio si coinvolgono solo gli esperti necessari a rispondere; ad esempio una rete da 56B con 8 esperti è capace di memorizzare le informazioni di tutti i parametri ma computazionalmente l’inferenza costa più o meno quanto interrogare un modello da 7B. È uno degli approcci seguiti da Deep Seek R1 per ottimizzare il carico computazionale.

Empiricamente, il costo energetico sembra essere migliorato in proporzione di più per i modelli online rispetto a quelli eseguiti localmente, anche grazie alle economie di scala che sono possibili quando si costruiscono grandi infrastrutture, e in ogni caso il costo energetico per token da GPT 3 a modelli paragonabili moderni è calato di un ordine di grandezza in poco piu di due anni.

Va anche detto che tutti i principali operatori stanno introducendo meccanismi di caching che evitano di ricalcolare l’intero prompt riducendo comunque le invocazioni del modello. In effetti l’abilitazione delle cache riduce i costi anche quando si utilizzano direttamente le API.

Sostenibilità delle risorse nei modelli AI: sfide future

Se il costo in termini di risorse per token è in calo, dobbiamo però domandarci se l’aumento di utenti, della complessità dei prompt, e della dimensione degli output richiesti non compensino e anzi richiedano ancora più risorse. La dimensione del contesto dei modelli è infatti in continua crescita, e adesso i nuovi modelli che generano immagini e video sono decisamente più sofisticati di quelli che elaborano solo testo.

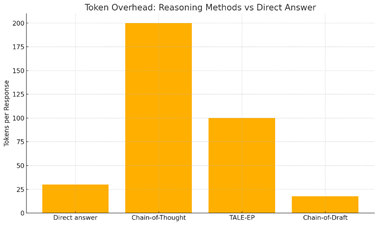

Un altro aspetto saliente è quello del ragionamento: l’applicazione della tecnica del chain of thought usata dai primi modelli richiede circa dieci volte più token per operare di fatto compensando l’ottimizzazione nell’esecuzione diretta del modello. Va detto che però si usano tecniche più sofisticate rispetto alla CoT, tra cui troviamo la Chain of Draft che aggiunge poco overhead rispetto alla risposta diretta del modello (in alcuni casi può addirittura costare meno per come è implementata).

Infine, l’introduzione degli agenti AI può portare ad un’automazione della produzione dei token che svolge un effetto moltiplicatore dei prompt elaborati dai modelli con un conseguente aumento della richiesta di potenza di calcolo e di conseguenza di maggiori risorse computazionali.

Si può sicuramente dire che l’ottimizzazione sia dei modelli che delle architetture di calcolo che li eseguono hanno ridotto significativamente i costi di elaborazione, ma l’incremento degli utenti, dell’uso che ne fanno e l’automazione che portano gli agenti rischiano di superare anche significativamente i risparmi dovuti alle ottimizzazioni. Solo il tempo ci consentirà di dire quale sarà il bilanciamento, per ora possiamo solo dire che le ottimizzazioni sono ancora significative e per ora possiamo contare sul fatto che i modelli possono ancora divenire più efficienti nell’uso delle risorse.

AI accessibile e sostenibile: verso soluzioni più efficienti

L’AI è una tecnologia sicuramente energivora, i modelli richiedono enormi capacità computazionali che vengono erogate da AI Factories in cui i server richiedono molte GPU per poter generare i token ad un ritmo che renda il servizio usabile. I dati che si trovano in letteratura sono preliminari e spesso ottenuti con stime solo indicative, e troppo spesso vengono usati per evocare scenari disastrosi.

La realtà è però che i datacenter a livello globale cominciano a rappresentare un uso significativo delle risorse, in particolare energetiche e idriche. Se per l’energia si può pensare di ricorrere a fonti naturali (tutti i grandi hanno promesso la carbon neutrality entro il 2030) o ad energia nucleare il vero collo di bottiglia è l’acqua.

L’acqua dolce sappiamo essere una risorsa che non abbonda e anche il raffreddamento evaporativo può creare microclimi molto umidi il cui impatto ambientale può essere significativo. Soluzioni alternative di raffreddamento possono prevedere circuiti chiusi di acqua (che quindi non evapora), che però sono meno efficaci e richiedono decisamente più energia per poter funzionare.

La buona notizia che le risorse contribuiscono ad aumentare i costi di esercizio che inevitabilmente spingeranno la ricerca di soluzioni più efficienti e quindi con impatti ambientali più ridotti. Vedremo come il panorama ICT globale affronterà queste sfide, e in particolare quella dell’acqua, nei prossimi anni, ma in linea di principio non si evidenziano limiti che facciano pensare ad un’impossibilità di disporre di una AI accessibile a tutti che sia allo stesso tempo sostenibile. In fondo il cervello umano richiede circa venti Watt per funzionare, sembra quindi che ci sono ampi margini di miglioramento.